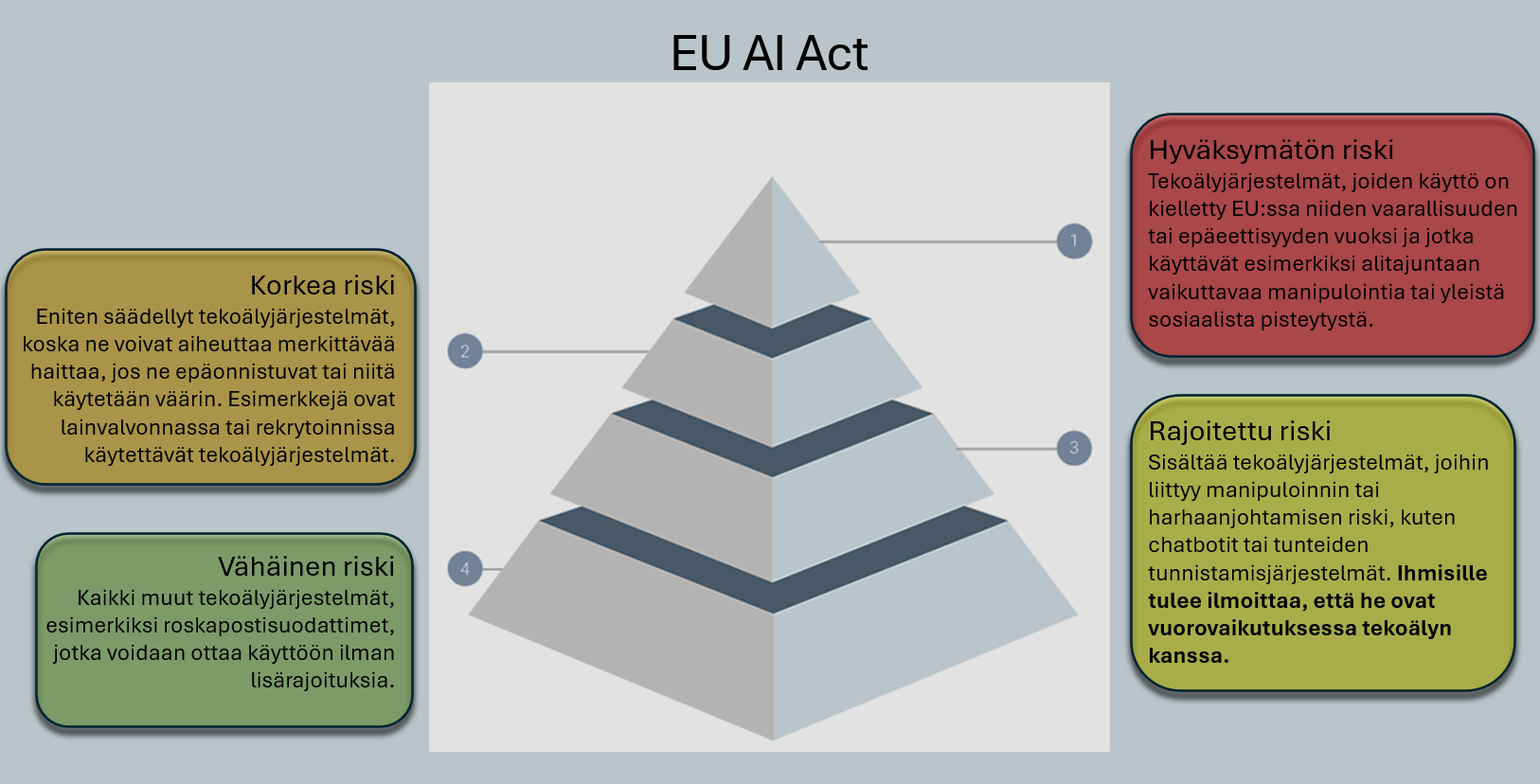

Riskitasot havainnollistavat AI Actin eri sääntelyluokkia.

Tekoälylainsäädäntö vuonna 2025 – EU ja muu maailma

Tekoäly (AI) on viime vuosina harpannut valtavin askelin eteenpäin, mikä näkyy kaikkialla yhteiskunnassa: terveydenhuollossa, taloudessa, liikenteessä ja arjessa. Kehityksen huima vauhti on tuonut mukanaan uudenlaisia riskejä, jotka voivat pahimmillaan vaarantaa sekä yksilöiden oikeuksia että yhteiskunnan vakautta. Tästä syystä lainsäädännön rooli on noussut keskeiseen asemaan: miten varmistetaan, että tekoälyä kehitetään ja käytetään turvallisesti, eettisesti ja ihmisoikeuksia kunnioittaen?

Elokuussa 2024 Euroopan unioni julkaisi pitkään valmistellun tekoälyasetuksensa (AI Act). Julkaisun jälkeen on käynnistynyt siirtymäaika, jonka aikana yrityksille ja muille toimijoille on tarjottu mahdollisuus sopeutua uuteen sääntelyyn. Kun AI Actin ensimmäiset säännökset tulevat voimaan 2. helmikuuta 2025, ne tuovat myös ensimmäiset sitovat säännökset tekoälyn käyttöön. Miksi tämä on tärkeää?

Yksinkertaistetusti: jos järjestelmää käytetään tavalla, joka aiheuttaa “hyväksymättömän riskin” – esimerkiksi vaarantaa turvallisuuden tai ihmisoikeudet – seuraukset voivat olla raskaat. Pahimmillaan sakot saattavat nousta 35 miljoonaan euroon tai 7 prosenttiin yrityksen maailmanlaajuisesta liikevaihdosta. Nähtäväksi kuitenkin jää, miten EU tulee käytännössä valvomaan ja toimeenpanemaan näitä sääntöjä, sekä kuinka oikeusjärjestelmä soveltaa niitä eri tilanteissa. On selvää, että sääntelyn tavoitteena on suojella kansalaisia ja yhteiskuntaa, mutta samalla se edellyttää yrityksiltä aiempaa tarkempaa riskienhallintaa ja valvontaa.

Euroopan unioni edelläkävijänä – vai liiankin innokkaana säätäjänä?

EU on jo aiemmin osoittanut olevansa edelläkävijä teknologian sääntelyssä: GDPR-asetus (General Data Protection Regulation) loi vankan pohjan yksityisyydensuojalle. Uudet säännökset saivat kuitenkin jo tuoreeltaan osakseen kritiikkiä: useat pienet ja keskisuuret yritykset kokivat, että tiukat vaatimukset vaikeuttivat nopeaa innovaatiota ja loivat raskaan hallinnollisen taakan. Toisaalta kansalaisjärjestöt pitivät GDPR:ää tärkeänä askeleena yksityisyyden suojaamisessa.

Nyt tekoälyä koskevalla AI Actilla EU pyrkii jälleen asettamaan kansainvälisen standardin siitä, miten kehittyneet algoritmit ja oppivat järjestelmät tulee suunnitella, testata ja ottaa käyttöön. Samalla kun EU:ta kiitellään proaktiivisesta lähestymistavasta, on myös kriitikoita, jotka pelkäävät sääntelyn hidastavan Euroopan kasvavaa tekoälyekosysteemiä ja pahentavan entisestään kilpailua eri alueiden, kuten Yhdysvaltojen ja Aasian, kanssa.

EU:n lainsäädäntö asettaa erityisen painon vastuun jakautumiselle tekoälyjärjestelmien kehittäjien ja käyttäjien välillä. Käytännössä tämä tarkoittaa, että kehittäjien tulee huolehtia järjestelmän turvallisuudesta ja läpinäkyvyydestä läpi sen elinkaaren, kun taas käyttäjillä on velvollisuus toimia ohjeiden mukaisesti ja varmistaa, ettei AI-järjestelmää käytetä väärin tai tarkoituksenvastaisesti. Kriittiset äänet tosin huomauttavat, että hajautettu vastuu voi johtaa tilanteeseen, jossa kukaan ei kanna täyttä vastuuta.

Neljä riskitasoa

Uusi asetus luokittelee tekoälysovellukset neljään riskitasoon:

-

Hyväksymättömät riskit

Näitä ovat AI-sovellukset, jotka uhkaavat turvallisuutta, elinkeinoja tai ihmisoikeuksia. Esimerkkeinä on mainittu hallitusten harjoittama sosiaalinen pisteytys tai tekoälypohjaiset lelut, jotka kannustavat vaaralliseen toimintaan. Tällaiset sovellukset on kielletty kokonaan, ja niiden kehittäminen tai käyttäminen voi johtaa ankarimpiin mahdollisiin sanktioihin. -

Korkean riskin sovellukset

Tähän kategoriaan kuuluvat esimerkiksi terveydenhuollon, kriittisen infrastruktuurin tai työvoiman hallinnan AI-järjestelmät. Näiden käyttöön liittyy tiukat valvonta- ja ennakkotarkastusvaatimukset. Organisaatioiden on pystyttävä todistamaan, että niiden järjestelmät ovat turvallisia, eettisiä ja syrjimättömiä. -

Rajoitetun riskin sovellukset

Näissä korostuu erityisesti läpinäkyvyys. Esimerkkinä voidaan mainita chatbotit, joiden tulee kertoa käyttäjälleen olevansa tekoäly. Tavoitteena on, että ihmiset ymmärtävät keskustelevansa AI:n kanssa ja pystyvät tarvittaessa valvomaan tai keskeyttämään järjestelmän toiminnan. -

Vähäriskiset tai riskittömät sovellukset

Näitä ovat vaikkapa roskapostisuodattimet ja tekoälypohjaiset videopelit. Ne tuottavat harvoin merkittäviä yhteiskunnallisia tai yksilöllisiä riskejä, joten niiden käyttö on vapaata, eikä niihin kohdistu erillisiä vaatimuksia lainsäädännössä.

Miksi lainsäädäntö on ajankohtaista juuri nyt?

Kehitys ei ole enää vain harvojen käsissä. Kielimallien ja generatiivisten AI-ratkaisujen saralla toimijat kuten OpenAI, Googlen DeepMind ja Anthropic etenevät valtavalla vauhdilla. Tekniset edistysaskeleet avautuvat kenen tahansa ulottuville, mikä kasvattaa sekä mahdollisuuksia että riskejä.

EU:n tekoälyasetus on kehitetty vastaamaan tähän todellisuuteen: vastuullisuus ja turvallisuus eivät saa jäädä kasvun ja kilpailun jalkoihin. Yhtenä tavoitteena on myös ylläpitää kansalaisten luottamusta teknologiaan, sillä ilman sitä kehitys voi kääntyä itseään vastaan. Toisaalta osa yrityksistä pelkää, että liian jäykät vaatimukset voivat ohjata sijoituksia pois Euroopasta ja synnyttää “säätelypaon” muihin maihin.

Yhdysvallat: markkinavetoista sääntelyä

Yhdysvallat lähestyy tekoälyn säätelyä toistaiseksi varsin eri tavoin. Vuonna 2025 maassa ei ole vielä yhtä kattavaa AI-lakia kuin EU:ssa, mutta alakohtaisia säännöksiä on otettu käyttöön esimerkiksi terveydenhuollon ja fintech-sektorin alueilla. Markkinoiden rooli on yhä keskeinen, ja monet yritykset, kuten Microsoft ja Google, laativat omia sisäisiä eettisiä ohjeistojaan.

On kuitenkin nähtävissä, että EU:n AI Act herättää kiinnostusta Yhdysvalloissa: siellä seurataan tarkasti, millaisia vaikutuksia tiukemmalla EU-sääntelyllä on tekoälyn kehittämiseen ja kilpailuun. Jotkut analyytikot arvelevat, että jos AI Act todetaan toimivaksi, Yhdysvallat saattaa ottaa siltä oppia – toisaalta on myös heitä, jotka ennustavat päinvastaista eli kevyempää sääntelyä kilpailukyvyn ja sijoitusystävällisyyden varmistamiseksi.

Aasia: Kiinan ja Japanin erilaiset strategiat

Kiinassa tekoälyä ohjaavat valtiojohto ja sen strategiset tavoitteet, kuten talouskasvu ja kansainvälinen kilpailukyky. Vuoteen 2025 mennessä maa on julkaissut AI-kehittäjille omat ohjeistot, jotka keskittyvät turvallisuuteen ja yhteiskunnan vakauteen. Valtion valvonta on varsin kattavaa, eikä kriittinen keskustelu tekoälyn eettisistä kysymyksistä ole yhtä avointa kuin länsimaissa.

Japanissa taas yhteistyö yritysten, hallituksen ja akateemisen maailman välillä on tiivistä, mutta sääntely on pehmeämpää kuin EU:ssa. Siellä erityishuomio on tekoälyn soveltamisessa ikääntyvän väestön tarpeisiin: esimerkkeinä robotiikka ja terveydenhuolto, joissa Japani on tunnetusti maailman huippua.

Kansainväliset standardit horisontissa

Tekoälyyn liittyvä kehitys on väistämättä globaalia, mikä korostaa kansainvälisen yhteistyön tarvetta. YK:n alaisuudessa on keskusteltu tekoälyn maailmanlaajuisista säännöistä, mutta sitovaa sopimusta ei vielä ole.

EU:n AI Act voi kuitenkin osoittautua samanlaiseksi esikuvaksi kuin GDPR, sillä monet maat pohtivat nyt, miten tasapainottaa innovaation edistäminen ja riskien hallinta. Jos EU:n malli osoittautuu menestykseksi, on mahdollista, että muutkin valtiot ottavat siitä mallia – näin tapahtui aikoinaan tietosuoja-asetuksenkin kohdalla. Samaan aikaan on muistettava, että GDPR:ää kritisoidaan yhä monissa piireissä liian raskaasta hallinnosta, joten globaali harmonisoituminen ei ole itsestäänselvyys.

Vastuunjakoon liittyvät kysymykset

Tekoälyjärjestelmät kehittyvät harvoin yhden tahon voimin. Mukana on usein alihankkijoita, pilvipalveluntarjoajia ja data-alustoja, joilla kaikilla on roolinsa lopputuloksen turvallisuudessa ja toimivuudessa. AI Act vaatii yrityksiltä entistä tarkempaa dokumentointia ja valvontaa, jotta ne pystyvät osoittamaan noudattavansa lain vaatimuksia – ja jotta mahdollisiin ongelmiin voidaan puuttua ajoissa.

- Sopimusmallit ja roolien selkeys: Vastuut on jaettava selkeästi: kuka kantaa juridisen vastuun, jos järjestelmä toimii virheellisesti tai aiheuttaa vahinkoa?

- Läpinäkyvyyden vaatimus: Kaikkien toimijoiden on kyettävä osoittamaan, miten tietoa kerätään, käytetään ja suojataan. Myös algoritmien mahdollisia vinoumia ja syrjiviä vaikutuksia pitää pystyä kartoittamaan etukäteen.

Mitä tämä tarkoittaa käytännössä?

EU:n AI Actin tarkoitus ei ole tukahduttaa innovaatiota, vaan varmistaa, että tekoälyä käytetään vastuullisesti ja ihmisten perusoikeuksia kunnioittaen. Tämä tarkoittaa esimerkiksi, että yritysten on jatkossa panostettava:

- Riskienhallintaan ja -arviointiin

- Syrjimättömyyteen

- Läpinäkyvyyteen

- Reiluuteen

Ennen järjestelmän käyttöönottoa on tehtävä ennakkotutkimus sen mahdollisista riskeistä, ja käyttöönoton jälkeen järjestelmää seurataan jatkuvasti. Kriittinen kysymys on, kuka tekee arvioinnin ja millaisilla kriteereillä?

Algoritmit eivät saa asettaa ihmisryhmiä eriarvoiseen asemaan esimerkiksi sukupuolen, iän tai etnisen taustan perusteella. Toisaalta monet kehittäjät kokevat syrjimättömyyden takaamisen käytännössä haasteelliseksi etenkin silloin, kun datan keruussa on vinoumia.

Käyttäjillä on oikeus tietää, milloin he ovat tekemisissä tekoälyn kanssa – ja miten dataa hyödynnetään päätöksenteossa. Joillekin toimijoille tämä voi tarkoittaa merkittäviä muutoksia nykyisiin käytäntöihin ja viestintätapoihin.

Tavoitteena on, että tekoäly hyödyttää koko yhteiskuntaa eikä vain pientä joukkoa kehittäjiä tai suuryrityksiä. Kriitikot tosin huomauttavat, että tehokasta valvontaa on vaikea järjestää, ja sääntelyn tulkinta voi vaihdella maittain.

Lopuksi

Vuosi 2025 on merkittävä käännekohta tekoälylainsäädännössä. EU:n tuore asetus toimii globaalina suunnannäyttäjänä, ja muut talousalueet seuraavat tilannetta tarkasti. Kansainvälisen sääntelyn harmonisoituminen voi ottaa aikansa, mutta tekoälyn mullistava vaikutus näkyy jo nyt eri sektoreilla.

Tekoäly voi parhaimmillaan parantaa ihmisten elämää – esimerkiksi nopeuttaa terveydenhuollon diagnostiikkaa, sujuvoittaa arkisia palveluita ja luoda täysin uusia työpaikkoja. Samalla on kuitenkin huolehdittava siitä, ettei teknologiaa käytetä väärin tai että se luo uusia, näkymättömiä riskirakenteita yhteiskuntaan. Kuten GDPR:nkin kohdalla, AI Act kerää varmasti sekä kiitosta että kritiikkiä, joten tulevien vuosien aikana on jännittävää nähdä, millaiseen tasapainoon sääntely ja innovaatiot asettuvat.

Lainsäädännön seuraaminen on siis jokaisen organisaation ja kansalaisen etu. Tieto ja avoin keskustelu auttavat varmistamaan, että tekoälyn tulevaisuus on turvallinen, reilu ja kaikkien saatavilla.

© 2025 AIvoille.com

Lähteet

- Euroopan komissio: Europe's approach to Artificial Intelligence

- Euroopan komissio: Proposal for a Regulation on Artificial Intelligence (AI Act) – COM/2021/206 final

- GDPR-info: Tietosuoja-asetuksen keskeiset kohdat

- European Data Protection Board: EDPB (tietosuoja-asetukseen liittyvä ohjeistus)